Arquitectura de contexto en archivos

Este «paper» plantea que el contexto de la IA debe gestionarse como un sistema de archivos.

La Filosofía Unix Aplicada a los Agentes de IA

Todo: memorias, herramientas, fuentes externas y notas humanas, se organiza como archivos en un espacio común, con un repositorio persistente que separa historial, memoria a largo plazo y scratchpads temporales. Así, el modelo solo carga el contexto necesario en cada llamada, registra cada cambio con trazabilidad y usa componentes para reducir, actualizar y evaluar el contexto. Esto se implementa en AIGNE, que unifica prompts dispersos en una capa de contexto reutilizable.

Todo es Contexto:

¿Y si tratáramos el contexto de la IA de la misma manera que Unix trata todo lo demás, como un archivo?

La Revolución de la Ingeniería de Contexto

¿Recuerdas cuando la ingeniería de prompts era la nueva habilidad de moda?

Bueno, es hora de subir de nivel. La ingeniería de contexto está emergiendo como el verdadero desafío arquitectónico en la construcción de sistemas de IA confiables, y está transformando fundamentalmente cómo pensamos sobre la memoria, el conocimiento y el razonamiento de la IA.

El artículo:

Propone algo bellamente simple pero profundo: aplicar la filosofía Unix de «todo es un archivo» a la gestión del contexto de IA.

El Problema: El Caos del Contexto

Si has construido algo con LLMs, te has encontrado con estas pesadillas:

- Límites de la Ventana de Tokens: Tu IA tiene la memoria de trabajo de un pez dorado con un techo de 128K tokens.

- Sin Estado: Cada conversación comienza desde cero; tu IA tiene amnesia perpetua.

- Degradación del Contexto: El conocimiento deriva, se vuelve obsoleto, se contradice a sí mismo.

- Razonamiento No Rastreable: ¿De dónde vino esa alucinación? Buena suerte encontrándolo.

Las soluciones actuales están fragmentadas. RAG por aquí, almacenes de memoria por allá, integraciones de herramientas en algún otro lugar; todo operando como islas independientes sin gobernanza unificada.

La Solución: Un Sistema de Archivos Virtual para el Contexto de IA

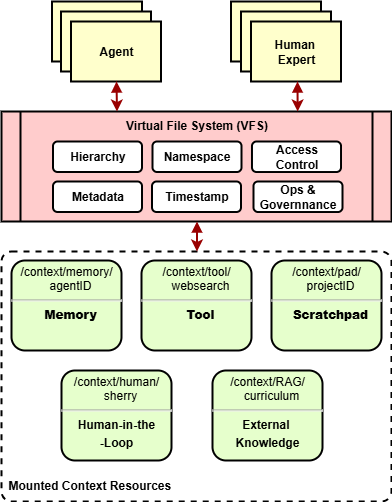

El «paper» introduce una abstracción de Sistema de Archivos Virtual (VFS) donde fuentes heterogéneas de contexto (memoria, herramientas, conocimiento externo, entrada humana) se montan y acceden de manera uniforme.

/context/

├── memory/

│ └── agentID/ # Memorias específicas del agente

├── tool/

│ └── websearch/ # Definiciones y estado de herramientas

├── pad/

│ └── projectID/ # Bloc de notas temporal

├── human/

│ └── sherry/ # Contribuciones humanas en el ciclo

└── RAG/

└── curriculum/ # Bases de conocimiento externasCada pieza de contexto se convierte en un ciudadano de primera clase con:

- Un espacio de nombres (ruta direccionable).

- Metadatos (marcas de tiempo, procedencia, controles de acceso).

- Operaciones (leer, escribir, buscar, transformar).

- Gobernanza (versionado, registros de auditoría, políticas de acceso).

Los Tres Pilares de la Ingeniería de Contexto

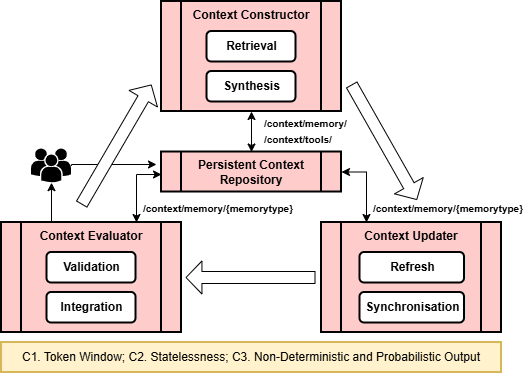

La arquitectura define tres componentes centrales que forman un pipeline de ciclo cerrado:

Constructor de Contexto

¿Qué entra en la ventana de tokens?

El Constructor selecciona, prioriza y comprime el contexto del repositorio persistente. Gestiona el brutal equilibrio entre completitud (toda la información relevante) y límites (ajustarse al límite de tokens).

Operaciones clave:

- Consultar metadatos para puntuación de relevancia.

- Aplicar compresión (resumen, embedding, clustering).

- Generar un manifiesto de contexto: un registro rastreable de qué se incluyó y por qué.

Actualizador de Contexto

¿Cómo mantenemos el contexto fresco durante el razonamiento?

Tres modos de operación:

- Instantánea estática: Inyección de contexto de una sola vez para tareas simples.

- Streaming incremental: Carga progresiva mientras el razonamiento se desarrolla.

- Actualización adaptativa: Intercambio en caliente de fragmentos obsoletos en tiempo real.

Evaluador de Contexto

¿La IA lo hizo bien? ¿Deberíamos recordar esto?

El Evaluador cierra el ciclo:

- Valida las salidas contra el contexto fuente.

- Detecta alucinaciones y contradicciones.

- Activa revisión humana cuando la confianza es baja.

- Escribe el conocimiento verificado de vuelta al almacén persistente.

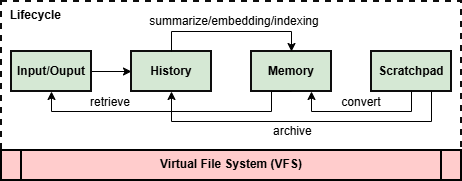

La Jerarquía de Memoria: No Solo Corto Plazo vs Largo Plazo

El artículo introduce una taxonomía matizada de tipos de memoria:

| Tipo de Memoria | Alcance Temporal | Qué se Almacena | Representación |

| Bloc de notas | Temporal | Turnos de diálogo, estados de razonamiento | Texto plano/embeddings |

| Episódica | Limitada a sesión | Resúmenes de sesión, historiales de casos | Resúmenes |

| Factual | Largo plazo | Declaraciones atómicas | Pares clave-valor/tripletas |

| Experiencial | Entre tareas | Trayectorias observación-acción | Registros estructurados |

| Procedimental | Todo el sistema | Funciones, herramientas, APIs | Referencias de código |

| Usuario | Personalizada | Preferencias, atributos | Perfiles de usuario |

| Histórica | Inmutable | Registros crudos de todo | Texto plano + metadatos |

El ciclo de vida fluye:

Entrada → Historial → Memoria → Bloc de notas → Archivo

Cada transición es un cambio de estado rastreable con marcas de tiempo y metadatos de linaje.

Restricciones de Diseño: La Física de la Arquitectura LLM

Tres restricciones fundamentales dan forma a todo:

Ventana de Tokens (El Techo Duro)

Los 128K tokens de GPT-4, los 200K de Claude: estas no son sugerencias, son **límites arquitectónicos**. Cada decisión de contexto debe respetar este límite mientras maximiza la densidad de información.

Sin Estado (Amnesia Perpetua)

Los LLMs no recuerdan sesiones anteriores. Punto. Toda la persistencia debe ser externa, lo que significa que tu sistema de archivos se convierte en la fuente de verdad.

No Determinismo (Caos Probabilístico)

Mismo prompt, diferentes salidas. La temperatura y el muestreo hacen de la reproducibilidad un desafío. El sistema de archivos debe preservar pares entrada-salida para auditoría y reproducción.

Principios de Ingeniería de Software Aplicados

La belleza de la abstracción del sistema de archivos es cuán naturalmente se alinea con los principios establecidos de IS:

| Principio | Aplicación |

| Abstracción | Interfaz uniforme oculta backends heterogéneos |

| Modularidad | Cada fuente de contexto es un punto de montaje independiente |

| Encapsulamiento | Lógica interna aislada, API mínima expuesta |

| Separación de Responsabilidades | Capas de datos vs herramientas vs gobernanza |

| Trazabilidad | Cada operación registrada como una transacción |

| Composabilidad | Espacio de nombres consistente permite integración sin código de pegamento |

El Factor Humano: Copilotos, No Solo Usuarios

Quizás el aspecto más visionario: los humanos no son solo usuarios finales, son participantes activos en la ingeniería de contexto.

/context/human/sherry/ # Conocimiento curado por humanos

/context/human/annotations/ # Correcciones y perspectivas

/context/human/overrides/ # Intervenciones explícitasEl juicio humano, el conocimiento tácito y el razonamiento ético se convierten en elementos de contexto de primera clase. Cuando la IA tiene incertidumbre, activa la revisión humana. Las anotaciones humanas se almacenan con procedencia completa.

Esto no es solo IA asistiendo a humanos, es verdadera colaboración humano-IA donde ambas partes contribuyen a la base de conocimiento en evolución.

Implementación en el Mundo Real: Framework AIGNE

El artículo no es solo teoría. Está implementado en el [Framework AIGNE](https://github.com/agentic-labs/aigne), demostrando viabilidad práctica:

Ejemplo 1: Agente con Memoria Habilitada

import { AIAgent } from "@aigne/core";

import { AFS } from "@aigne/afs";

import { AFSHistory } from "@aigne/afs-history";

import { UserProfileMemory } from "@aigne/afs-user-profile-memory";

const sharedStorage = { url: "file:./memory.sqlite3" };

const afs = new AFS()

.mount(new AFSHistory({ storage: sharedStorage }))

.mount(new UserProfileMemory({ storage: sharedStorage }));

const agent = AIAgent.from({

instructions: "Eres un chatbot amigable",

afs, // El agente tiene acceso a todo el contexto montado

});Ejemplo 2: Servidor MCP como Montaje del Sistema de Archivos

const mcpAgent = await MCPAgent.from({

command: "docker",

args: ["run", "-i", "--rm", "ghcr.io/github/github-mcp"],

});

const afs = new AFS()

.mount(mcpAgent); // Herramientas de GitHub ahora en /modules/github-mcp/

// El agente ahora puede ejecutar afs_exec('/modules/github-mcp/search_repositories', {...})Cualquier servidor MCP se convierte en un recurso de contexto montable. GitHub, Slack, bases de datos: todo accesible a través de una interfaz de archivos unificada.

Por Qué Esto Importa para Tus Sistemas de IA

1. Depurabilidad

Cuando tu IA alucina, puedes rastrear exactamente qué elementos de contexto estaban en la ventana, su procedencia y por qué fueron seleccionados.

2. Gobernanza y Cumplimiento

Los controles de acceso, registros de auditoría y versionado vienen integrados. Esencial para sistemas de IA empresariales.

3. DevOps para Contexto

El contexto se vuelve versionable, desplegable y gestionable a través de prácticas estándar de data-ops, no ajustes de prompts ad-hoc.

4. Orquestación Multi-Agente

Los espacios de nombres compartidos permiten que los agentes colaboren mientras mantienen aislamiento y límites de acceso.

5. Alineación Humano-IA

Mecanismos explícitos para supervisión humana, corrección y contribución a la base de conocimiento.

El Futuro: Contexto Auto-Organizativo

Direcciones emocionantes:

- Navegación Agéntica: Agentes navegando, indexando y evolucionando autónomamente sus propias estructuras de archivos.

- Tejido de Conocimiento Vivo: Contexto que se auto-organiza, poda y consolida.

- Participación Humana Activa: Humanos como curadores de conocimiento y co-razonadores, no solo revisores.

Imagina agentes de IA que mantienen sus propios modelos del mundo como sistemas de archivos navegables y verificables: razonamiento, memoria y acción convergiendo en un sustrato unificado.

Puntos Clave

- Ingeniería de contexto > ingeniería de prompts: El verdadero desafío es gestionar todo el ciclo de vida de la información, no solo elaborar instrucciones individuales.

- Todo es un archivo: La filosofía Unix proporciona una abstracción probada en batalla para la gestión de recursos heterogéneos.

- Pipeline de tres etapas: Construir → Actualizar → Evaluar forma un ciclo cerrado para la gestión de contexto.

- La memoria es estratificada: Diferentes alcances temporales y representaciones sirven diferentes necesidades de razonamiento.

- Los humanos son participantes: La ingeniería de contexto debe soportar explícitamente la colaboración humano-IA.

- La trazabilidad no es negociable: Cada decisión de contexto debe ser registrada, versionada y auditable.

El cambio de ingeniería de prompts a ingeniería de contexto marca una maduración del campo de la IA: de elaborar instrucciones ingeniosas a construir sistemas robustos, rastreables y gobernables. La abstracción del sistema de archivos nos da una base familiar y poderosa sobre la cual construir.Lecturas clave sobre agentes de IA y sistemas de archivos

Hay un cambio profundo en la forma en que los agentes de IA manejan memoria, herramientas y contexto. Estos artículos lo muestran desde distintos ángulos y, juntos, apuntan a una misma idea: los sistemas de archivos están convirtiéndose en una pieza central del diseño de agentes, no en un simple detalle técnico.

How agents can use filesystems for context engineering

Blog de LangChain

🔗 https://www.blog.langchain.com/how-agents-can-use-filesystems-for-context-engineering/

Este artículo explica cómo los agentes pueden leer, escribir y buscar archivos para superar los límites del contexto. En lugar de forzar todo dentro de un prompt, el agente puede externalizar conocimiento, actualizar instrucciones y trabajar con grandes volúmenes de información de forma más estable. El enfoque es práctico: mejor razonamiento y mayor control del comportamiento del agente.

Introducing bash-tool for filesystem-based context retrieval

Vercel

🔗 https://vercel.com/changelog/introducing-bash-tool-for-filesystem-based-context-retrieval

Vercel presenta una herramienta open source que permite a los agentes ejecutar comandos Bash sobre el sistema de archivos de forma segura. Así, el contexto se obtiene directamente desde archivos, reduciendo el uso de tokens y aumentando la precisión. Es una idea muy alineada con la filosofía Unix: operaciones simples, límites claros y mayor observabilidad.

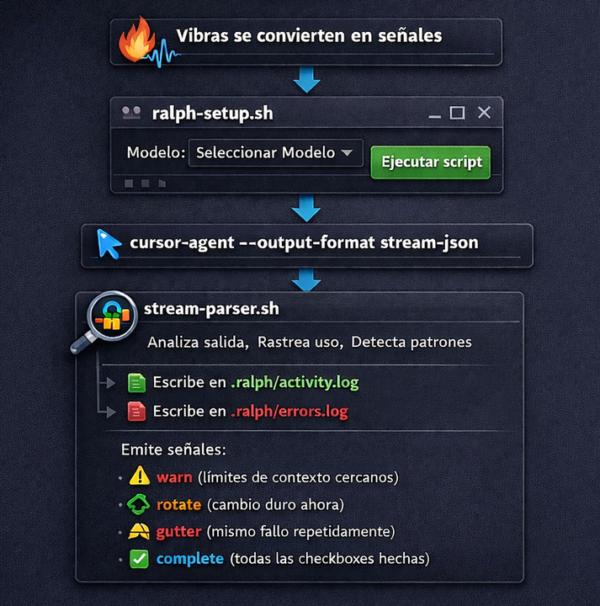

ralph for idiots: the only explanation you need

Hilo en X

🔗 https://x.com/agrimsingh/status/2010412150918189210

Este hilo explica de forma directa la técnica “ralph” para programación asistida por IA. Comparte usos reales, errores comunes (como plugins poco confiables) y alternativas más sólidas basadas en planificación y scripts. Informal, pero lleno de lecciones prácticas.

Files Are All You Need

LlamaIndex

🔗 https://www.llamaindex.ai/blog/files-are-all-you-need

El texto sostiene que los archivos son la interfaz natural para que los agentes trabajen con datos no estructurados. Más allá del RAG tradicional, los archivos permiten memoria persistente, reutilización de habilidades y una separación más limpia entre razonamiento y almacenamiento. También señala lo que aún falta, como mejores mecanismos de parsing y búsqueda.

Benchmarking AI Agent Memory: Is a Filesystem All You Need?

Letta

🔗 https://www.letta.com/blog/benchmarking-ai-agent-memory

Letta pone a prueba esta idea con benchmarks reales. Sus resultados muestran que un enfoque simple basado en archivos para almacenar y buscar conversaciones puede superar sistemas más complejos como grafos de conocimiento. La conclusión es clara: la simplicidad y la autonomía del agente pueden pesar más que infraestructuras sofisticadas.